Diplomado en Big Data y ciencia de datos

Herramientas para la producción, almacenamiento, procesamiento, análisis, interpretación y comunicación de grandes volúmenes de datos, para encontrar soluciones más exactas e innovadoras a muchos desafíos de las organizaciones.

Aprende en forma aplicada a tratar los datos para abrir nuevas oportunidades de negocio o crecimiento.

Antecedentes Generales

Para enfrentar los nuevos desafíos de datos, es necesario saber almacenar, administrar, procesar y analizar grandes cantidades de datos. La complejidad de los datos requiere nuevas y poderosas técnicas analíticas, por lo tanto, es crucial tener habilidades para comunicar e interpretar los resultados de este análisis. El manejo de estas habilidades cae bajo el dominio de los Data Scientists o Data Engineers profesionales que son altamente demandados por el mercado. El Diplomado en Big Data y ciencias de datos entrega competencias básicas para poder comenzar a trabajar con datos rápidamente o iniciarse en el camino hacia convertirse en un especialista en el futuro.

Las clases son de tipo expositivo y talleres aplicados con metodología hands on. Todas las actividades teóricas y prácticas buscan potenciar las habilidades de capacidad de análisis, toma de decisiones y el trabajo en equipo, a través de la presencia y participación del alumno en las sesiones de los cursos. El diplomado cuenta además con un seminario de introducción a big data, data science e inteligencia artificial.

Profesionales que deseen enfrentarse al desafío de sacar el mejor provecho posible a datos de gran tamaño y complejidad, a través de nuevas e innovadoras técnicas, con el objetivo de impactar la toma de decisiones en sus negocios. Está orientado a profesionales como ingenieros, economistas, y otros profesionales licenciados y/o con experiencia en áreas afines, que requieren conocimientos y habilidades en la materia.

Aplicar principios, y técnicas de modelamiento y visualización de la ciencia de datos para el análisis y solución de problemas de negocio.

El alumno debe estar en posesión de un grado académico o de un título profesional universitario:

– Licenciatura en ciencias de la ingeniería o título de ingeniería civil.

– Otro grado académico o título profesional universitario en una disciplina afín, como ingeniería comercial, economía, agronomía, etc., cuyo nivel sea al menos equivalente al necesario para obtener el grado de licenciado.

– Experiencia laboral de dos años en al área o áreas afines.

Contenidos del Programa

Al final del seminario podrás:

– Identificar las principales diferencias big data, data science e inteligencia artificial y qué esperar de estos.

– Reflexionar sobre el impacto de estas tecnologías y técnicas en los negocios y la vida actual.

Contenidos:

– Tendencias tecnológicas y la estrategia: big data, IoT, análisis de datos, inteligencia artificial y machine learning.

– Big data: Definiciones, arquitecturas , Map-Reduce, Hadoop, Spark.

– Bases de datos, data warehouses y data lakes.

Al final del curso podrás:

– Comprender las principales tecnologías asociadas a big data y reconocer bajo qué contexto utilizarlas.

– Diseñar arquitecturas de alto nivel en proyectos relacionados a business intelligence y big data.

– Generar ambientes de alta disponibilidad para proyectos de data science y big data.

– Identificar los conceptos de infraestructura big data en servicios de consumo on demand (servicios en la nube).

Contenidos:

– Tecnologías y servicios en la nube para BI, big data y data science.

– Procesamiento de datos eficiente con tecnologías big data.

– Diseño de arquitecturas de alta disponibilidad para BI y big data.

– Diseño y uso de infraestructura de alto rendimiento para algoritmos de data science.

– Estrategias y mejores prácticas en el desarrollo de componentes para arquitecturas de procesamiento masivo de datos.

– Diferencias entre soluciones de datos tradicionales y soluciones de big data.

– Gestión operativa de la infraestructura en un modelo de servicio continuo.

Al final del curso podrás:

– Revisar conceptos básicos de programación usando el lenguaje R.

– Usar el lenguaje R como una herramienta para analizar datos.

– Utilizar los sistemas gráficos de R para visualización de datos.

– Analizar conjuntos de datos utilizando los principios del análisis exploratorio de datos.

– Explicar la información visual contenida en los gráficos que generan R.

– Exponer los resultados de un análisis de datos.

Contenidos:

– Conceptos generales de programación en R: variables, estructuras de control, condicionales.

– Funciones y paquetes.

– Vectores y matrices.

– Listas.

– Data frames.

– Importación, limpieza y filtrado de datos.

– Dataframes: construcción y mezcla.

– Visualización gráfica.

– Análisis estadístico de datos con R: población y muestreo, tipos de datos, tablas de frecuencias, estadísticos descriptivos, coeficiente de posición y dispersión, errores de los procesos de medición, aplicaciones.

– Distribuciones de probabilidad.

– Regresión lineal con R.

– Regresión logística con R.

– Series de tiempo.

Al final del curso podrás:

– Identificar las principales teorías y prácticas de la emergente área de minería de datos.

– Desarrollar soluciones a problemas reales de big data y ciencia de datos que involucren la necesidad de técnicas de minería de datos.

– Implementar soluciones usando herramientas de software de minería de datos aplicándolas en datos reales.

Contenidos:

– Introducción: El concepto, el proceso y los problemas en que es relevante.

– Análisis de la canasta de mercado y reglas de asociación.

– Clasificación: Árboles de decisión, K-vecinos cercanos.

– Clustering: K-Means, Mean-Shift y Clustering aglomerativo.

– Selección de modelos (hold out, cross validation).

Al final del curso podrás:

– Identificar la importancia de la visualización de datos.

– Aplicar los conceptos fundamentales de las técnicas de visualización, comunicación y diseño efectivo.

– Manejar técnicamente los principales programas de visualizaciones.

– Exponer los datos de manera gráfica.

– Implementar reportes y tableros de manera efectiva.

Contenidos:

Unidad 1: Teoría sobre visualización de datos

– Introducción: breve historia, disciplinas de comunicación gráfica e importancia de visualizar datos.

– La “des-Excelización” y democratización de datos en la empresa.

– Condiciones necesarias para una visualización: datos y caso.

– Objetivos de la visualización: Contenido vs usuario, acceso, interacción y actualización.

– Fuentes de información: sistemas transaccionales, sistemas web, datos públicos.

– Preparación de datos: integridad, calidad, homologación.

– Generalidades sobre tipos de datos: medidas, dimensiones.

– Atributos a usar en una visualización.

– Análisis de los tipos de gráficos más comunes para representar datos.

– Exploración visual de datos.

– Indicadores, reportes y dashboards.

– Presentación de las herramientas principales del mercado.

– Visualizaciones avanzadas: scripting.

Unidad 2: Visualización de datos aplicada

– Datos de empresa: reportes transversales a industrias y vistas especificas.

– Revisión de casos de uso de dashboards generales.

– Revisión de casos de uso específicos por industrias.

– Revisión de casos de uso por niveles de usuarios: analistas vs C-level.

Al final del curso podrás:

– Evaluar oportunidades de negocio accionables a partir del análisis de datos.

– Aplicar los conceptos y métodos fundamentales de data science a problemas reales de negocio, interpretando adecuadamente los resultados y generando acciones de valor agregado.

– Desarrollar modelos descriptivos, predictivos y prescriptivos sobre datos de diversas industrias.

Contenidos:

– La evolución de la ciencia de datos y el análisis predictivo para el apoyo a la toma de decisiones.

– Las características que definen a una organización data-driven.

– Cómo las empresas modernas están generando productos y servicios analíticos.

– Metodologías de análisis de datos y búsqueda de patrones.

– Generación de modelos descriptivos, análisis de casos reales y trabajo práctico.

– Generación de modelos predictivos y prescriptivos, análisis de casos reales y trabajo práctico.

– Cómo interpretar modelos analíticos para tomar mejores decisiones de negocio.

Al final del curso podrás:

– Distinguir potencias y limitaciones del Machine Learning y Deep Learning para la resolución de problemas en diferentes industrias.

– Detectar situaciones y su contexto en las cuáles estas técnicas resolverían problemas de gran valor de negocio.

– Proponer un plan estratégico de desarrollo de tecnología basada en ciencia de datos, alineado con la estrategia corporativa.

– Utilizar modelos de redes neuronales profundas en contextos de Visión Computacional que sean capaces de detectar objetos e interpretar contenido de imágenes.

– Aplicar modelos de procesamiento de lenguaje natural para la resolución de problemas en textos no-estructurados de diferentes tipos y orígenes.

Contenidos:

Introducción, conceptos, gestión de datos

– Metodología de desarrollo de modelos (CRISP-DM, KDD, otros).

– Pre-procesamiento de datos.

Evaluación y selección de modelos

– Workflow de evaluación. Hold out, Cross Validation, refinamiento de hiper-parámetros.

– Métricas de evaluación. Accuracy, Precision, Recall, RMSE.

Modelos de aprendizaje automático supervisado

– Modelos de regresión numérica. Regresión Lineal y no-lineal.

– Modelos de clasificación, capacidades y características, así como ejemplos de aplicación. Entre los modelos: Árbol de Decisión, Random Forest, KNN, Naive Bayes, SVM, Redes Neuronales.

Modelos de aprendizaje no-supervisados

– K-Means, DBSCAN, HDBSCAN.

Modelos de aprendizaje profundo

– Introducción y conceptos esenciales.

– Ejemplos de aplicaciones en visión computacional y en procesamiento de lenguaje natural con modelos pre-entrenados (ej: YOLO).

– Características de las redes neuronales y conceptos básicos (álgebra lineal, funciones de mapeo).

– Diferentes topologías de redes profundas: FFN, Convolucional.

– Aplicación en contextos de información No-Estructurada: procesamiento de video (Visión Computacional), procesamiento de texto natural (NLP y NLU), – Word Embedding, Redes Neuronales Convolucionales.

– Modelos no-supervisados Profundos: Autoencoders, GAN, y especialmente, Transformers y modelos generativos.

Cuerpo Docente

Jefe de Programa

Jaime Navón Cohen

Profesor Asociado del Departamento de Ciencia de la Computación UC. Ph.D. Computer Science, University of North Carolina at Chapel Hill.

Néstor Campos Rojas

Gerente de Proyectos Estratégicos y Jefe de Arquitectura de Soluciones en Metric Arts. Cuenta con más de 8 años de experiencia en el desarrollo de software en todas sus etapas.

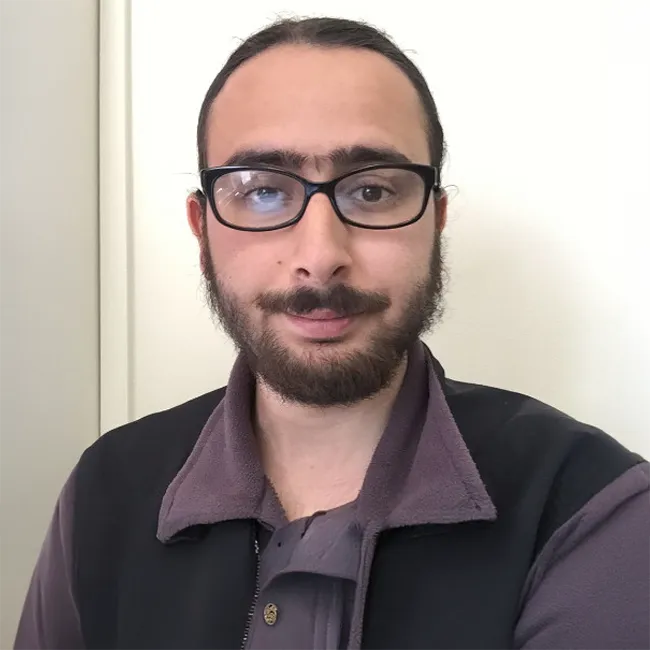

Nicolas Ceroni Perisic

MBA, IE Business School. Data Analytics Certificate, Massachusetts Institute of Technology (MIT). Máster en Ingeniería Industrial, UC.

Miguel Jorquera Viguera

Senior Data Scientist Consultant en EY

Joshua Kunst

Magíster en Estadísticas, UC. Dedicado a la ciencia de datos, modelamiento predictivo y visualización de datos.

Jaime Navón Cohen

Profesor Asociado del Departamento de Ciencia de la Computación UC. Ph.D. Computer Science, University of North Carolina at Chapel Hill.

Sebastián Raveau

Profesor Asistente de Ingeniería de Transporte y Logística UC. Doctor en Ciencias de la Ingeniería e Ingeniero Civil de Industrias, mención en Transporte, UC.

Rodrigo Sandoval

Profesor de Ciencias de la Computación de la Escuela de Ingeniería UC. CEO y fundador de R:Solver. Experto en Ingeniería de Software e IA.

Hernán Valdivieso

Magíster en Ciencias de la Ingeniería e Ingeniero Civil en Computación, UC. Profesor Instructor del Departamento de Ciencia de la Computación de la Escuela de Ingeniería UC. Su área de trabajo es el desarrollo de técnicas de visualización.